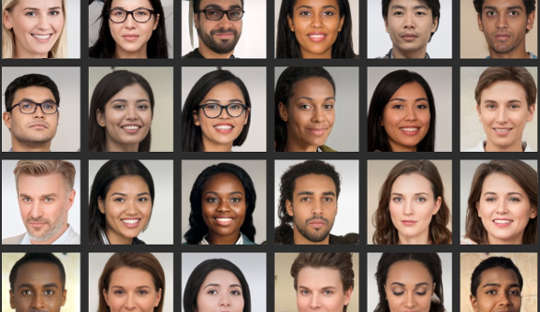

भले ही आपको लगता है कि आप चेहरों का विश्लेषण करने में अच्छे हैं, अनुसंधान से पता चला बहुत से लोग वास्तविक चेहरों की तस्वीरों और कंप्यूटर जनित छवियों के बीच विश्वसनीय रूप से अंतर नहीं कर सकते हैं। यह अब विशेष रूप से समस्याग्रस्त है कि कंप्यूटर सिस्टम उन लोगों की यथार्थवादी-दिखने वाली तस्वीरें बना सकते हैं जो मौजूद नहीं हैं।

हाल ही में, एक कंप्यूटर जनित प्रोफ़ाइल चित्र वाली एक नकली लिंक्डइन प्रोफ़ाइल ने समाचार बनाया क्योंकि यह अमेरिकी अधिकारियों और अन्य प्रभावशाली व्यक्तियों के साथ सफलतापूर्वक जुड़े नेटवर्किंग प्लेटफॉर्म पर, उदाहरण के लिए। काउंटर-इंटेलिजेंस विशेषज्ञ यहां तक कहते हैं कि जासूस नियमित रूप से ऐसी तस्वीरों के साथ फैंटम प्रोफाइल बनाते हैं सोशल मीडिया पर विदेशी निशाने पर घर.

ये डीप फेक रोजमर्रा की संस्कृति में व्यापक होते जा रहे हैं, जिसका अर्थ है कि लोगों को इस बारे में अधिक जागरूक होना चाहिए कि मार्केटिंग, विज्ञापन और सोशल मीडिया में उनका उपयोग कैसे किया जा रहा है। छवियों का उपयोग दुर्भावनापूर्ण उद्देश्यों के लिए भी किया जा रहा है, जैसे कि राजनीतिक प्रचार, जासूसी और सूचना युद्ध।

उन्हें बनाने में डीप न्यूरल नेटवर्क नामक एक कंप्यूटर सिस्टम शामिल है, जो मस्तिष्क के सीखने के तरीके की नकल करता है। यह वास्तविक चेहरों के तेजी से बड़े डेटा सेटों को उजागर करके "प्रशिक्षित" है।

वास्तव में, दो गहरे तंत्रिका नेटवर्क एक दूसरे के खिलाफ सेट होते हैं, जो सबसे यथार्थवादी छवियों का निर्माण करने के लिए प्रतिस्पर्धा करते हैं। नतीजतन, अंतिम उत्पादों को GAN इमेज कहा जाता है, जहां GAN का मतलब जनरेटिव एडवरसैरियल नेटवर्क है। यह प्रक्रिया उपन्यास छवियां उत्पन्न करती है जो प्रशिक्षण छवियों से सांख्यिकीय रूप से अप्रभेद्य हैं।

आईसाइंस में प्रकाशित हमारे अध्ययन में, हमने दिखाया कि इन कृत्रिम चेहरों को वास्तविक चीज़ों से अलग करने में विफलता का हमारे ऑनलाइन व्यवहार पर प्रभाव पड़ता है। हमारे शोध से पता चलता है कि नकली छवियां दूसरों पर हमारा भरोसा कम कर सकती हैं और जिस तरह से हम ऑनलाइन संवाद करते हैं, उसे गहराई से बदल सकते हैं।

मेरे सहयोगियों और मैंने पाया कि लोगों ने GAN चेहरों को वास्तविक लोगों के चेहरों की वास्तविक तस्वीरों की तुलना में अधिक वास्तविक दिखने वाला माना। हालांकि यह अभी तक स्पष्ट नहीं है कि ऐसा क्यों है, यह खोज करती है प्रौद्योगिकी में हाल की प्रगति पर प्रकाश डालें कृत्रिम चित्र बनाने के लिए उपयोग किया जाता है।

और हमें आकर्षकता के लिए एक दिलचस्प कड़ी भी मिली: जिन चेहरों को कम आकर्षक के रूप में रेट किया गया था उन्हें भी अधिक वास्तविक के रूप में रेट किया गया था। कम आकर्षक चेहरों को अधिक विशिष्ट और विशिष्ट माना जा सकता है ठेठ चेहरे को संदर्भ के रूप में इस्तेमाल किया जा सकता है जिसके खिलाफ सभी चेहरों का मूल्यांकन किया जाता है। इसलिए, ये GAN चेहरे अधिक वास्तविक दिखेंगे क्योंकि वे मानसिक टेम्पलेट्स के समान हैं जो लोगों ने रोजमर्रा की जिंदगी से बनाए हैं।

लेकिन इन कृत्रिम चेहरों को प्रामाणिक के रूप में देखने के सामान्य स्तर के भरोसे के परिणाम भी हो सकते हैं जो हम अपरिचित लोगों के एक समूह तक बढ़ाते हैं - एक अवधारणा जिसे "सामाजिक विश्वास" के रूप में जाना जाता है।

हम अक्सर अपने द्वारा देखे जाने वाले चेहरों में बहुत अधिक पढ़ते हैं, और हमारे द्वारा बनाई गई पहली छापें हमारे सामाजिक संबंधों को निर्देशित करती हैं. हमारे नवीनतम अध्ययन का हिस्सा बनने वाले एक दूसरे प्रयोग में, हमने देखा कि लोग उन चेहरों द्वारा बताई गई सूचनाओं पर भरोसा करने की अधिक संभावना रखते थे, जिन्हें वे पहले वास्तविक मानते थे, भले ही वे कृत्रिम रूप से उत्पन्न हुई हों।

यह आश्चर्य की बात नहीं है कि लोग उन चेहरों पर अधिक भरोसा करते हैं जिन्हें वे वास्तविक मानते हैं। लेकिन हमने पाया कि ऑनलाइन बातचीत में कृत्रिम चेहरों की संभावित उपस्थिति के बारे में लोगों को सूचित किए जाने के बाद भरोसा खत्म हो गया था। फिर उन्होंने विश्वास के निचले स्तर को दिखाया, कुल मिलाकर - इस बात से स्वतंत्र कि चेहरे वास्तविक थे या नहीं।

इस परिणाम को कुछ मायनों में उपयोगी माना जा सकता है, क्योंकि इसने लोगों को एक ऐसे वातावरण में अधिक संदिग्ध बना दिया है जहाँ नकली उपयोगकर्ता संचालित हो सकते हैं। हालाँकि, दूसरे दृष्टिकोण से, यह धीरे-धीरे हमारे संवाद करने के तरीके की प्रकृति को नष्ट कर सकता है।

सामान्य तौर पर, हम काम करते हैं एक डिफ़ॉल्ट धारणा है कि अन्य लोग मूल रूप से सच्चे और भरोसेमंद हैं. नकली प्रोफाइल और अन्य कृत्रिम ऑनलाइन सामग्री में वृद्धि से यह सवाल उठता है कि उनकी उपस्थिति और उनके बारे में हमारा ज्ञान इस "सत्य डिफ़ॉल्ट" स्थिति को कितना बदल सकता है, अंततः सामाजिक विश्वास को नष्ट कर सकता है।

हमारे डिफ़ॉल्ट को बदलना

एक ऐसी दुनिया में संक्रमण जहां जो वास्तविक है वह अविभाज्य है जो सांस्कृतिक परिदृश्य को मुख्य रूप से कृत्रिम और भ्रामक होने के लिए मुख्य रूप से सत्य होने से भी बदल सकता है।

यदि हम नियमित रूप से ऑनलाइन अनुभव की सत्यता पर सवाल उठा रहे हैं, तो इसके लिए हमें संदेशों के प्रसंस्करण से लेकर संदेशवाहक की पहचान के प्रसंस्करण तक के अपने मानसिक प्रयासों को फिर से तैनात करने की आवश्यकता हो सकती है। दूसरे शब्दों में, अत्यधिक यथार्थवादी, फिर भी कृत्रिम, ऑनलाइन सामग्री के व्यापक उपयोग से हमें अलग तरह से सोचने की आवश्यकता हो सकती है - जिस तरह से हमने उम्मीद नहीं की थी।

मनोविज्ञान में, हम "वास्तविकता की निगरानी" नामक एक शब्द का उपयोग करते हैं कि हम कैसे सही ढंग से पहचानते हैं कि बाहरी दुनिया से कुछ आ रहा है या हमारे दिमाग के भीतर से। प्रौद्योगिकियों की उन्नति जो नकली, फिर भी अत्यधिक यथार्थवादी, चेहरे, चित्र और वीडियो कॉल का उत्पादन कर सकती है, का अर्थ है कि वास्तविकता की निगरानी हमारे अपने निर्णयों के अलावा अन्य सूचनाओं पर आधारित होनी चाहिए। यह व्यापक चर्चा के लिए भी कहता है कि क्या मानव जाति अभी भी सत्य के लिए डिफ़ॉल्ट हो सकती है।

डिजिटल चेहरों का मूल्यांकन करते समय लोगों का अधिक आलोचनात्मक होना महत्वपूर्ण है। इसमें रिवर्स इमेज सर्च का उपयोग करके यह जांचना शामिल हो सकता है कि तस्वीरें वास्तविक हैं या नहीं, कम व्यक्तिगत जानकारी या बड़ी संख्या में फॉलोअर्स वाले सोशल मीडिया प्रोफाइल से सावधान रहना, और नापाक उद्देश्यों के लिए इस्तेमाल की जाने वाली डीपफेक तकनीक की क्षमता के बारे में जागरूक होना।

नकली डिजिटल चेहरों का पता लगाने के लिए इस क्षेत्र के लिए अगली सीमा बेहतर एल्गोरिदम होनी चाहिए। इसके बाद इन्हें सोशल मीडिया प्लेटफॉर्म में एम्बेड किया जा सकता है ताकि नए कनेक्शन के चेहरों की बात आने पर असली को नकली से अलग करने में हमारी मदद की जा सके।

के बारे में लेखक

मनोस साकिरिस, मनोविज्ञान के प्रोफेसर, भावनाओं की राजनीति केंद्र के निदेशक, लंदन की रॉयल होलोवे विश्वविद्यालय

इस लेख से पुन: प्रकाशित किया गया है वार्तालाप क्रिएटिव कॉमन्स लाइसेंस के तहत। को पढ़िए मूल लेख.